Révolution ou continuité ?

La science n’a jamais produit et traité autant de données. Si bien que pour certains, nous serions entrés dans le 4e paradigme scientifique, celui de l’exploration des données. Mais Matthias Dörries, professeur en histoire des sciences et épistémologie, inscrit le big data dans une tradition plus longue.

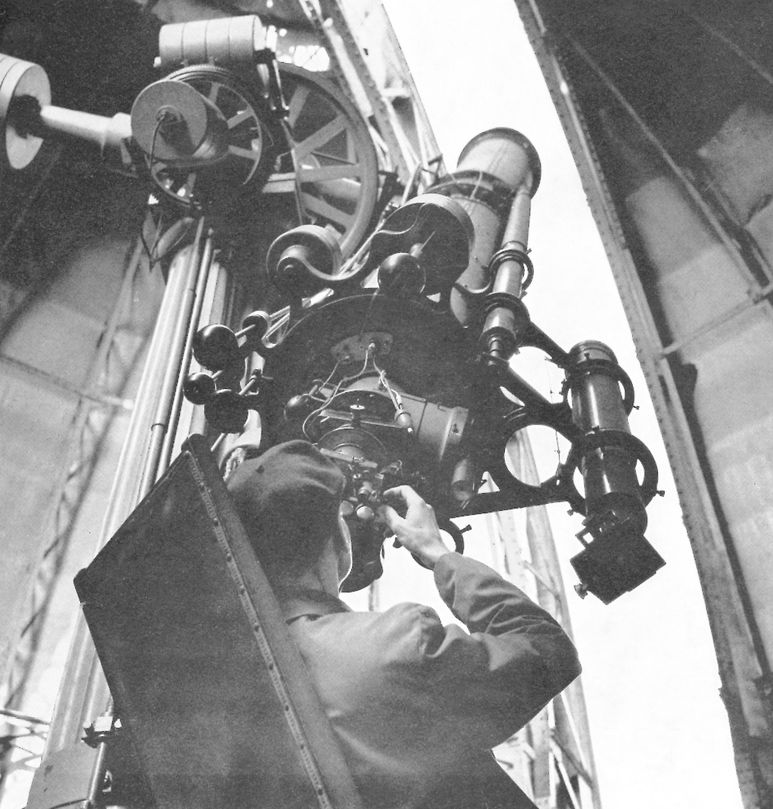

A l’échelle mondiale, le volume de données produites en 2014 s’élèverait selon le chercheur américain Atul Butte à 4 zettaoctets (4 fois 1021), soit quatre mille milliards de milliards d’octets. À lui seul, le LHC (Large Hadron Collider), l’accélérateur de particules qui a montré l’existence du Boson de Higgs, délivre 40 millions de données par seconde. Des chiffres vertigineux. Les données sont tellement massives qu’elles dépassent les capacités humaines et que seuls les algorithmes sont capables de les explorer. Pour Jim Gray, chercheur américain en informatique, cette évolution représente le 4e paradigme scientifique. Selon son analyse, la science s’est d’abord construite sur l’empirisme, à partir de l’observation des phénomènes naturels (1er paradigme), puis sur les théories qui généralisent ces observations, comme les lois de la physique de Newton ou Kepler (2e paradigme), avant de recourir, au XXe siècle, aux programmes informatiques et à la simulation pour modéliser les problèmes complexes.

Matthias Dörries ne croit pas en de telles ruptures radicales, il y voit une « continuité » : « Je resterais prudent, c’est une vision très générale. Certes, l’informatique ouvre de nombreuses possibilités, on peut utiliser les données d’une manière totalement inattendue, et elle rend possible des résultats qui ne l’étaient pas avant. Par exemple, le traitement des masses de données météorologiques a permis de modéliser le climat. Mais je ne crois pas que cela change fondamentalement la recherche. C’est une autre façon de faire, qui s’ajoute aux autres », estime-t-il.

Ordonner la nature

Pour lui, la problématique du traitement des données évolue à travers le temps et dans des contextes. « La classification est un moyen de traiter les données, on a besoin de mettre de l’ordre, comme le font les programmes informatiques aujourd’hui. Linné, par exemple, a proposé un classement des plantes pour ordonner la grande diversité de la nature. » Matthias Dörries rappelle les phases de l’histoire marquées par le souci d’amasser des données pour contrôler, dominer, prévoir. A partir de l’époque de Napoléon, on a eu la volonté de collecter et de centraliser un ensemble de données du territoire pour administrer le pays. « C’était déjà des données massives en quelque sorte. De même, dans le contexte de la guerre froide qui se jouait sur toute la Terre, les deux superpuissances ont cherché à accumuler un grand nombre de données à l’échelle globale. »

Comme si le big data était la solution

La vitesse d’obtention des données et les capacités de stockage augmentent exponentiellement. Le programme « 1000 génomes » a, par exemple, permis d’obtenir davantage de données en 6 mois que le projet GenBank pendant ses 21 ans d'existence. Mais pour l’historien, ce n’est pas l’enjeu principal. « Le terme "big" ne veut pas dire grande chose et donne l’impression d’une simple célébration de cette nouvelle technologie. Comme si big data était la solution, mais ce n’est pas aussi facile. Cette accélération n’est pas la réponse à nos problèmes. Elle rend le travail du scientifique plus rapide et commode. On peut séquencer les génomes, mais que fait-on avec cette suite d’acides nucléiques ? Les conséquences pour la société me semblent intéressantes à questionner. Les enjeux du big data ne se limitent pas aux sciences. Nous sommes dans une culture des données, que l’on veut rendre accessibles, transparentes. La démocratie demande la transparence, mais je crains une société dans laquelle les données massives seraient accessibles de partout par n’importe qui. Une société totalement transparente serait inquiétante. »

Mots-clés

- Recherche

- numérique

- équipement

- big data